Data Factory

Die Data Factory in Microsoft Fabric ist das Herzstück der modernen Datenintegration.

Sie ermöglicht Unternehmen, Daten aus unterschiedlichsten Quellen zentral zu verbinden, zu transformieren und automatisiert bereitzustellen – ganz ohne komplexe Programmierung.

Mit ihrer intuitiven Low-Code-Oberfläche kombiniert Data Factory einfache Bedienbarkeit mit der Leistungsfähigkeit moderner Cloud-Technologie.

So können selbst komplexe Integrations- und Ladeprozesse (ETL/ELT) effizient umgesetzt und flexibel an neue Anforderungen angepasst werden.

Ob für Data Warehouses, Lakehouses oder Data Science Workloads – die Microsoft Fabric Data Factory sorgt dafür, dass Daten immer dort zur Verfügung stehen, wo sie gebraucht werden.

Typische Einsatzszenarien

- Tägliche Beladung von Data Warehouses oder Lakehouses

- Automatisierte Datenbereitstellung für Reporting und Analytics

- Zusammenführung von On-Premises- und Cloud-Datenquellen

- Migration bestehender Azure Data Factory-Prozesse in Microsoft Fabric

- Integration von Echtzeitdaten für Monitoring und Prognosen

Fähigkeiten

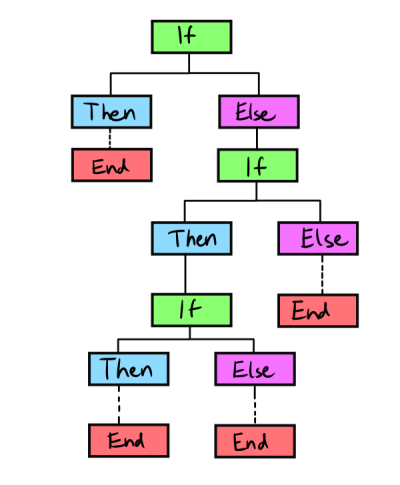

Die Data Factory ist innerhalb von Microsoft Fabric das zentrale Werkzeug für visuelle Datenintegration, Orchestrierung und Automatisierung von Datenflüssen.

- Visuelle Pipeline-Erstellung per Drag & Drop – ohne aufwändiges Coding

- Über 200 Konnektoren zu Datenbanken, APIs, Cloud-Speichern und On-Premises-Systemen

- Integration mit OneLake, Power BI, Data Warehouse und Spark

- Flexible Transformationen mit Data Flows, Mapping Data Flows und Data Wrangling

- Zeitgesteuerte Ausführungen und Event-getriggerte Workflows

- Monitoring & Alerting über Fabric Workspace – inklusive Pipeline-Status und Laufzeitstatistiken

- Parametrisierung und Wiederverwendung von Pipelines für agile Entwicklung

- Sicherer Zugriff über Managed Identities und rollenbasierte Berechtigungen

- Nahtlose Integration mit GitHub und Azure DevOps für Versionierung und CI/CD

- Skalierbare Ausführung großer Datenvolumen – vom Batch-Job bis zum Near-Real-Time-Load

Leistungen

Wir begleiten Unternehmen von der ersten Konzeption bis zum stabilen Produktivbetrieb.

Unsere Expertise deckt alle Schritte moderner Datenintegration ab – technisch, fachlich und organisatorisch.

- Analyse und Konzeption von Datenflüssen und Integrationsarchitekturen

- Aufbau und Implementierung von Data Factory Pipelines (ETL/ELT)

- Einrichtung automatisierter Ladeprozesse für Data Warehouse, Lakehouse und Reporting

- Entwicklung von Data Flows zur Transformation und Harmonisierung heterogener Datenquellen

- Integration externer Systeme (z. B. SAP, Oracle, REST-APIs, CRM-Systeme)

- Monitoring, Logging und Fehlerbehandlung mit Fabric-Mitteln

- Versionierung und Deployment via GitHub / Azure DevOps

- Optimierung bestehender Data Factory-Prozesse hinsichtlich Performance und Kosten

- Schulung und Coaching für Data Engineers und Administratoren