Business Analytics

Mit Microsoft Fabric beginnt eine neue Ära des Data Warehousing.

Die Plattform vereint Datenintegration, Data Engineering, Data Science, Reporting und Governance in einer einheitlichen Cloud-Umgebung – vollständig verwaltet, hoch skalierbar und tief mit Power BI integriert.

Während klassische Data Warehouses häufig getrennte Systeme für ETL, Speicherung und Analyse benötigen, bringt Microsoft Fabric alles zusammen:

Alle Daten liegen zentral im OneLake, Microsofts universellem Datenspeicher, und können direkt von verschiedenen Workloads genutzt werden – ohne aufwändige Datenbewegungen oder Duplikate.

Microsoft Fabric vereint Data Engineering, Data Warehousing, Data Science und Business Intelligence in einer integrierten Cloud-Plattform. Wir entwickeln modulare, skalierbare Lösungen, die Daten aus unterschiedlichen Quellen zusammenführen, transformieren und für Analyse und Reporting bereitstellen.

Unser Fokus liegt auf der technischen Umsetzung: von der Data-Lakehouse-Architektur über automatisierte Datenpipelines bis hin zu Power BI-Reports und Machine-Learning-Integration.

Data Lakehouse-Entwicklung

Wir entwickeln moderne Lakehouse-Architekturen, die die Vorteile von Data Lake und Data Warehouse kombinieren. Durch Fabric’s OneLake und Synapse Data Engineering schaffen wir eine einheitliche Plattform für strukturierte und unstrukturierte Daten.

Technologien und Leistungen:

- Aufbau von Data-Lakehouse-Strukturen mit Microsoft Fabric OneLake

- Entwicklung von Datenmodellen mit Synapse Data Warehouse

- Erstellung und Orchestrierung von Pipelines mit Data Factory

- Integration von Delta Tables, Parquet und SQL Endpoints

- Automatisierte Lade- und Transformationsprozesse mit Python und SQL

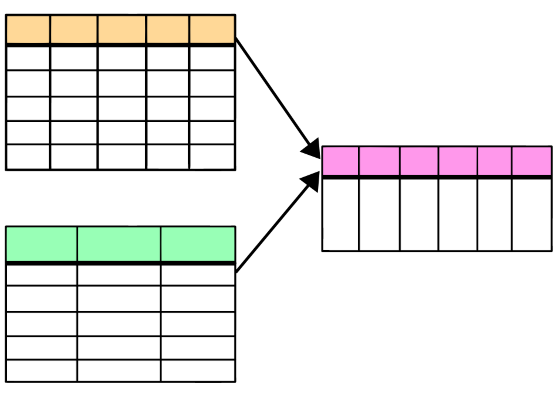

Datenintegration

Moderne Data-Warehouse-Architekturen benötigen mehr als nur Speicher und Datenmodelle – sie benötigen verlässliche, automatisierte und skalierbare Datenintegration.

Mit Microsoft Fabric steht Unternehmen eine vollständig integrierte Plattform zur Verfügung, die Data Engineering, ETL/ELT, Orchestrierung und Analyse vereint.

Wir unterstützen Sie dabei, diese neue Generation der Datenintegration optimal zu nutzen:

- Fabric Data Factory für visuelle, Low-Code-Orchestrierung

- Python & Spark Notebooks für flexible, performante Transformationen

- Pipelines, Dataflows Gen2 und Lakehouse-Integration für konsistente und zuverlässige Prozesse

Analytisches Reporting

Wir entwickeln integrierte Reporting- und Analyseumgebungen auf Basis von Power BI und Fabric Dataflows. Dabei verbinden wir die Vorteile einer zentralen Datenplattform mit flexiblen Visualisierungsmöglichkeiten.

Technologien und Leistungen:

- Datenaufbereitung mit Dataflows und Data Factory

- Aufbau semantischer Modelle und Datasets für Power BI

- Entwicklung interaktiver Dashboards und Berichte

- Automatisierte Aktualisierung und Monitoring von Datenquellen

- Integration von Python- und R-Skripten für erweiterte Analysen

Projektbeispiele und Einsatzszenarien

Banken und Versicherungen

Ziel: Vereinheitlichung und Automatisierung komplexer Datenlandschaften

Banken und Versicherungen arbeiten oft mit einer Vielzahl heterogener Systeme – Kernbanken- oder Policensysteme, CRM, Risikomodellierung, Regulatorik, externe Markt-Feeds.

Mit Microsoft Fabric Data Factory lassen sich diese Datenquellen zentral zusammenführen und automatisiert bereitstellen.

Typische Projekte

- Konsolidierung von Kundendaten aus Kernbanksystem, CRM und Onlinekanälen

- Automatisierte Berechnung von Risikokennzahlen über Data Factory-Pipelines

- Regulatorisches Reporting (z. B. EBA-, FINMA-, Solvency II-Datenfeeds) mit Integration in Power BI

- Aufbau eines zentralen Data Lakehouses für Data Science und Machine Learning

Logistik und Transportwesen

Ziel: Transparente Lieferketten und operative Echtzeit-Analysen

In der Logistik kommen Daten aus zahlreichen Quellen – GPS-Tracking, Transportmanagement-Systemen, Lagerverwaltung, Sensoren oder externen Dienstleistern.

Mit Fabric Pipelines und Spark lassen sich diese Daten nahezu in Echtzeit integrieren und analysieren.

Typische Projekte

- Zusammenführung von Sendungs- und Telematikdaten in einem zentralen Lakehouse

- Echtzeitüberwachung von Lieferketten über Power BI-Dashboards

- Prognosen von Lieferzeiten oder Auslastung mit Python/Spark-Analysen

- Automatische Datenaufbereitung für CO₂-Reporting und Nachhaltigkeitskennzahlen

Handel und E-Commerce

Ziel: Datengetriebene Entscheidungen im Einkauf, Vertrieb und Marketing

Im Handel entstehen Daten aus unterschiedlichsten Quellen – Kassensystemen, Online-Shops, Lagerbeständen, Kampagnen-Tools oder Social Media.

Microsoft Fabric ermöglicht eine einheitliche Sicht auf diese Daten und schafft damit die Basis für automatisierte Analysen und Forecasts.

Typische Projekte

- Integration von Verkaufs- und Bestandsdaten aus Filialen, Webshops und Lieferantenportalen

- Tägliche Aktualisierung von Umsatz- und Margenreports in Power BI

- Kunden- und Warenkorbanalysen mit Python/Spark

- Automatisiertes Kampagnen-Tracking und Performance-Reporting